3行でわかる今回のニュース

- AI詐欺が2026年に急増予測 — ディープフェイクを使った音声・動画詐欺が巧妙化

- Avast Deepfake Guardがリリース — リアルタイムでディープフェイクを検出するツール

- 「家族の声」を使った詐欺に注意 — 数秒の音声サンプルで声をクローン可能に

もうちょっと詳しく

AI詐欺の手口

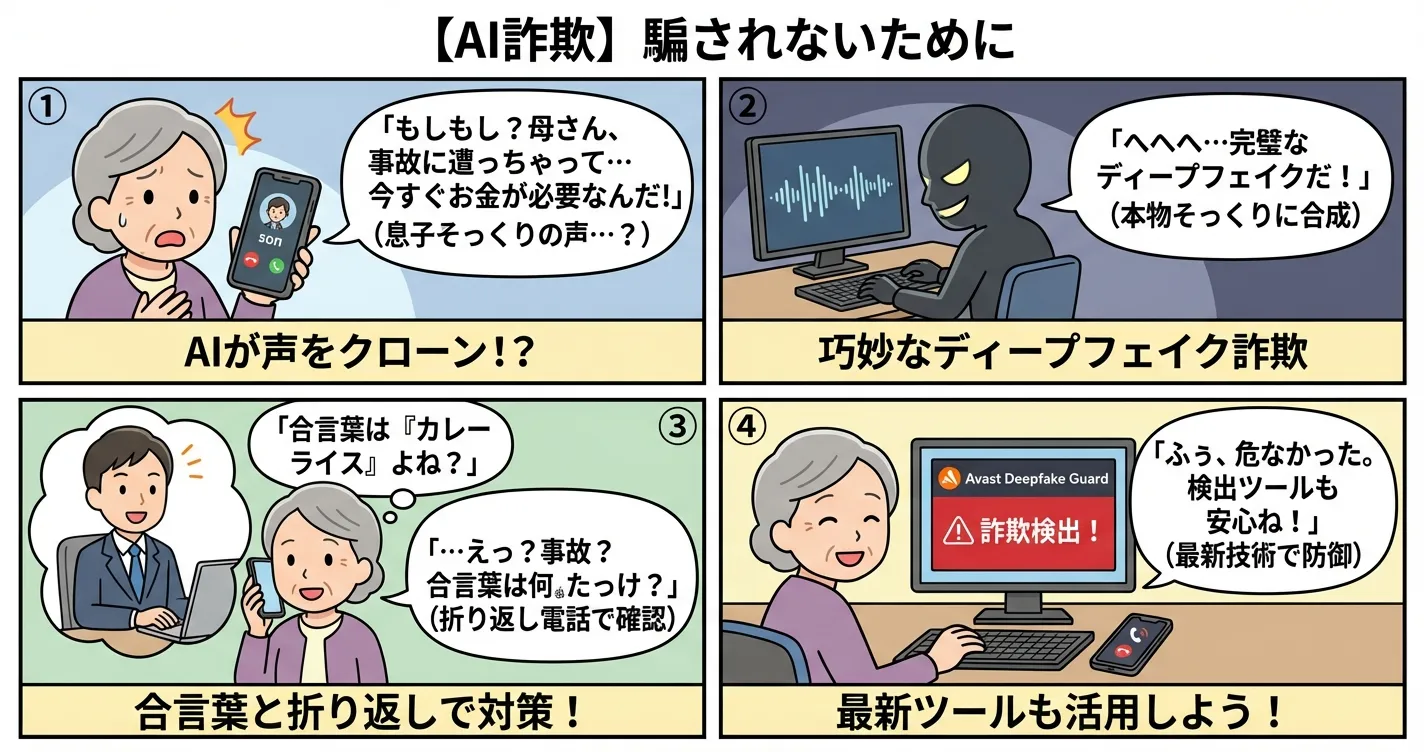

1. 音声クローン詐欺(ボイスフィッシング)

- 家族や上司の声をAIで再現

- 「事故に遭った」「緊急でお金が必要」と電話

- 数秒の音声サンプルがあれば複製可能

2. ディープフェイク動画詐欺

- 有名人や経営者の偽動画を作成

- 投資詐欺、暗号通貨詐欺に悪用

- ビデオ通話で本人になりすますケースも

3. AIフィッシングメール

- 文章の不自然さがなくなった

- 個人情報を元にパーソナライズ

- 従来の「怪しい日本語」では見抜けない

対策ツール

Avast Deepfake Guard(2026年2月リリース)

- リアルタイム検出 — ビデオ通話中にディープフェイクを警告

- Windows PC対応 — 低スペックPCでも動作

- AI駆動 — 新しい手法にも対応

その他の対策ツール

- Sensity AI — 企業向けディープフェイク検出

- UncovAI — ブラウザ拡張機能で詐欺サイト検出

- Microsoft Video Authenticator — 動画の改ざん検出

自分でできる対策

音声詐欺対策

- 合言葉を決めておく — 家族間で緊急時の合言葉を設定

- 折り返し電話する — 緊急の電話が来たら一度切って折り返す

- 不自然な間に注意 — AIは会話の「間」が不自然になりがち

動画詐欺対策

- 目の動きを見る — 瞬きが不自然、目が泳いでいる

- 輪郭を確認 — 顔と背景の境界がぼやけている

- 複数ソースで確認 — 公式サイト、複数メディアで情報確認

2026年の予測

Experianの予測によると:

- ディープフェイク採用面接の増加(偽の求職者)

- AIエージェントを使った自動詐欺

- スマートホームデバイス経由の攻撃

被害額は125億ドル(約1.8兆円)を超える見込みとされています。

まとめ

AI技術の進化は便利さと同時にリスクも生んでいます。

「AIで作られた」という前提で疑う習慣をつけること、そして対策ツールを導入することが重要です。

特に高齢の家族がいる場合は、合言葉を決めておくことを強くおすすめします。